Terwijl veel marketeers zich blindstaren op keywords en contentcreatie, ligt de echte basis voor SEO-succes vaak onder de motorkap: de technische gezondheid van je website. Na honderden technische audits voor clients heb ik telkens weer gezien hoe technische problemen zelfs de beste content en linkbuilding-strategieën kunnen ondermijnen.

Ontdek concrete methodes om technische SEO-problemen systematisch op te sporen en op te lossen, zodat je website optimaal presteert in zoekmachines. Geen theoretische concepten, maar bewezen aanpakken die direct resultaat opleveren.

De kern van een effectieve technische SEO audit

Een grondige technische SEO audit gaat verder dan het afvinken van een checklist. Het vereist een systematische benadering die de belangrijkste factoren identificeert die de zoekprestaties van jouw specifieke website beïnvloeden.

1. Crawlbaarheid: Kunnen zoekmachines je content vinden?

Het indexatieproces van Google begint met crawling. Als Google-bots niet efficiënt door je site kunnen navigeren, bestaat je content simpelweg niet voor zoekmachines. Dit is vaak het meest fundamentele probleem dat ik tegenkom bij websites die worstelen met organische zichtbaarheid.

Je robots.txt configuratie speelt hierbij een cruciale rol. Dit bestand geeft search engines instructies over welke delen van je website ze wel en niet mogen crawlen. Ik zie regelmatig dat webmasters per ongeluk belangrijke secties blokkeren door verkeerde instellingen in dit bestand.

Praktische tip: Gebruik Google Search Console's robots.txt tester (onder 'Indexering' > 'robots.txt tester') om te controleren of belangrijke URL's niet onbedoeld geblokkeerd worden. Voer steekproefsgewijs URL's in van kritieke pagina's en controleer of Googlebot ze mag crawlen.

Essentiële controles voor robots.txt:

- Controleer op onbedoelde blokkades van belangrijke content

- Verifieer dat essentiële mappen en bestanden toegankelijk zijn

- Beperk bewust crawling van niet-indexeerbare pagina's om crawl budget te sparen

XML sitemaps vormen een tweede fundamenteel element voor optimale crawlbaarheid. Ze werken als een roadmap voor zoekmachines, waardoor ze efficiënter kunnen navigeren en prioriteren. Toch zie ik vaak dat sitemaps verouderd zijn of pagina's bevatten die niet geïndexeerd zouden moeten worden.

Praktische tip: Controleer in Google Search Console onder 'Indexering' > 'Sitemaps' hoeveel van je ingediende URL's daadwerkelijk geïndexeerd zijn. Een groot verschil tussen ingediende en geïndexeerde URL's wijst op onderliggende problemen die aandacht vereisen.

Een goed gestructureerde interne linkstructuur is minstens zo belangrijk. Wanneer het niet op orde is, kunnen hele secties van je site onzichtbaar worden voor zoekmachines, zelfs als ze niet expliciet geblokkeerd zijn.

Kritische elementen van interne linkstructuur:

- Orphaned pages (niet gelinkt binnen de site) identificeren en oplossen

- Diepte van pagina's binnen je site-architectuur analyseren

- Link equity-distributie naar belangrijke pagina's optimaliseren

Een e-commerce platform waarmee ik werkte, ontdekte dat 42% van hun productpagina's niet gecrawld werden door een verkeerde robots.txt configuratie. Na correctie zagen ze een grote toename van organisch verkeer binnen drie weken doordat deze pagina's eindelijk werden geïndexeerd.

2. Indexeerbaarheid: Wordt je content correct verwerkt?

Crawlbaarheid betekent nog niet automatisch indexeerbaarheid. De volgende stap is ervoor zorgen dat Google je content begrijpt en waardevol genoeg vindt om op te nemen in de index.

Canonicalisatie is een van de meest voorkomende technische SEO-problemen die ik tegenkom. Zonder correcte canonical tags kan Google besluiten om de verkeerde versie van een pagina te indexeren, of erger nog, je content als duplicate beschouwen en helemaal niet indexeren.

Praktische tip: Gebruik de URL Inspection tool in Google Search Console om te controleren of Google de juiste canonical URL herkent. Als de gedetecteerde canonical afwijkt van wat je bedoeld hebt, heb je een probleem dat directe aandacht vereist.

Belangrijke canonicalisatie-controles:

- Duplicate content issues identificeren

- Correcte implementatie van canonical tags verifiëren

- URL-parameterproblemen oplossen die duplicates creëren

Naast canonicalisatie zijn indexeringscontroles onmisbaar. Dit betekent dat je moet nagaan of Google de pagina's die geïndexeerd zouden moeten worden, ook daadwerkelijk indexeert.

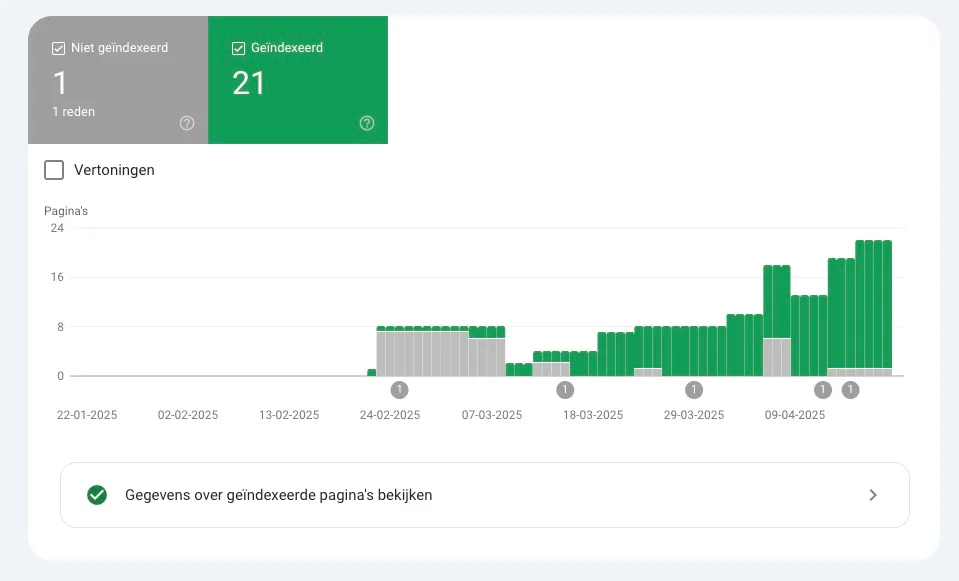

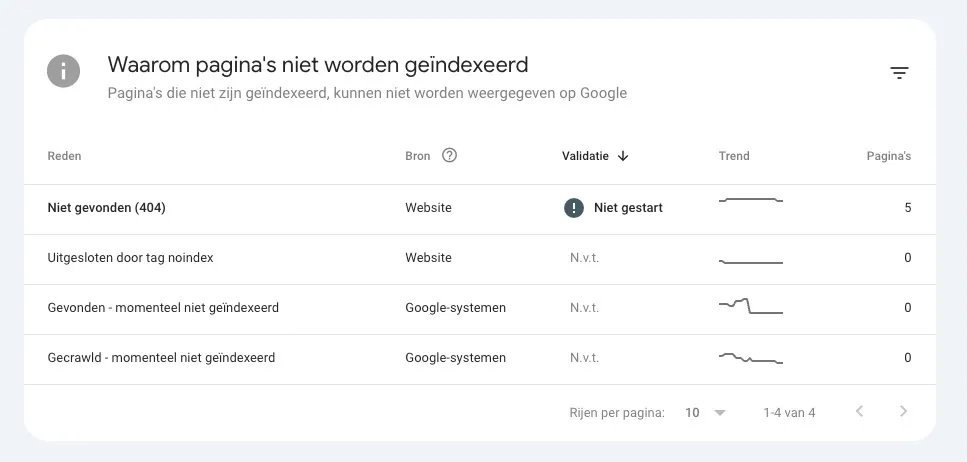

Praktische tip: Het rapport "Indexering" > "Pagina's" in Google Search Console geeft je direct inzicht in indexeringsproblemen. Let vooral op de "Uitgesloten" sectie, die je precies vertelt waarom bepaalde pagina's niet geïndexeerd zijn (zoals 'Ontdekt - momenteel niet geïndexeerd' of 'Geblokkeerd door robots.txt').

In de huidige JavaScript-gedreven web-omgeving zijn renderproblemen steeds vaker een struikelblok. Complexe JavaScript frameworks kunnen fantastisch zijn voor gebruikerservaring, maar als Google je content niet kan renderen, is het nutteloos voor SEO.

JavaScript SEO tip: Test of Google je JavaScript-pagina's correct rendert door de mobiele-vriendelijke test van Google te gebruiken. Deze toont zowel de gerenderde DOM als eventuele resources die geblokkeerd worden, wat cruciaal is voor het opsporen van renderingproblemen.

Een B2B-softwarebedrijf zag hun blog-prestaties stagneren totdat we ontdekten dat hun paginering werd geblokkeerd voor indexering. Door het implementeren van een correcte rel="next"/"prev" en canonicalisatiestrategie steeg hun long-tail verkeer binnen twee maanden.

Diepgaande analyse met technische hulpmiddelen

De echte waarde van een technische audit zit in het systematisch gebruik van gespecialiseerde tools om problemen bloot te leggen die het blote oog mist.

1. Site crawlers inzetten voor grondige analyse

Tools zoals Screaming Frog, Sitebulb of DeepCrawl bieden uitgebreide inzichten in de technische gezondheid van je website. Ze simuleren hoe zoekmachines door je website navigeren en identificeren een breed scala aan potentiële problemen.

Een volledige site-crawl kan tal van kritieke problemen aan het licht brengen die anders onzichtbaar blijven. Ik gebruik deze tools dagelijks om snel een overzicht te krijgen van technische problemen die directe aandacht vereisen.

Praktische Screaming Frog tips:

- Gebruik de "Custom Search" functie om specifieke problemen te vinden (zoals ontbrekende H1's of pagina's zonder meta descriptions)

- Stel filters in om alleen bepaalde pagina-types te analyseren (zoals productpagina's of blogartikelen)

- Exporteer crawl data naar Excel voor diepere analyse en het identificeren van patronen

Waardevolle inzichten uit site crawls:

- Broken links en 4xx/5xx fouten die gebruikerservaring schaden

- Title tags, meta descriptions en headings met duplicaties of lengteproblemen

- Redirect chains en loops die link equity verspillen

- Pagina's met lage content-to-HTML ratio

SEO-vriendelijke URL-structuur tip: Gebruik de bulk export van URL's uit Screaming Frog om URL-patronen te analyseren. Zoek naar inconsistenties zoals parameters, ID's of datumformaten die verwarring kunnen veroorzaken bij zoekmachines en gebruikers.

Naast volledige site-crawls zijn gerichte crawls vaak onmisbaar voor diepere analyse. In plaats van je hele site te crawlen, kun je focussen op specifieke secties of problemen.

2. Server- en hostinganalyse

Paginasnelheid en serverresponstijden zijn cruciale ranking-factoren die vaak over het hoofd worden gezien. Met de introductie van Core Web Vitals als officiële rankingfactor is dit belangrijker dan ooit.

Time To First Byte (TTFB) is een eerste indicatie van serverprestaties en beïnvloedt direct hoe snel zoekmachines je content kunnen crawlen. Een trage server kan je hele SEO-strategie ondermijnen, ongeacht hoe goed je andere optimalisaties zijn.

Praktische PageSpeed tips:

- Gebruik PageSpeed Insights niet alleen voor scores, maar ook voor de gedetailleerde aanbevelingen onder "Mogelijkheden" en "Diagnostiek"

- Verifieer Core Web Vitals prestaties in Google Search Console onder "Ervaring" voor een groter aantal pagina's

- Test je site vanaf verschillende geografische locaties met tools als GTmetrix om internationale prestatieproblemen te identificeren

Kern server- en hosting-factoren:

- Serverresponstijden (TTFB) evalueren over verschillende pagina's

- Core Web Vitals meten en optimaliseren (LCP, FID, CLS)

- CDN-implementatie controleren voor wereldwijde prestaties

Google Search Console CWV-tip: Check het rapport "Ervaring" > "Core Web Vitals" in GSC om te zien welke pagina-typen de meeste prestatieproblemen hebben. Dit helpt je te prioriteren welke templates of secties eerst moeten worden geoptimaliseerd.

Van diagnose naar implementatie

Het opsporen van problemen is slechts de eerste stap. De werkelijke waarde van een technische audit ligt in het prioriteren en oplossen van de gevonden issues.

1. Prioriteren van technische issues op basis van impact

Niet alle technische problemen zijn even belangrijk. Uit mijn ervaring weet ik dat focus op de juiste issues het verschil kan maken tussen marginale en substantiële verbeteringen.

De meest effectieve benadering is om problemen te prioriteren op basis van hun potentiële impact op zowel zoekprestaties als bedrijfsdoelstellingen. Dit voorkomt dat je tijd verspilt aan fixes die weinig verschil maken.

Praktische prioriteringsmethode:

- Markeer issues in Google Search Console met het label "Errror" als hoogste prioriteit, gevolgd door "Warning"

- Gebruik de Coverage en Enhancement rapporten om urgente indexerings- en rich snippet problemen te identificeren

- Controleer de "Performance" rapporten om pagina's met afnemende prestaties te identificeren, en geef technische problemen op deze pagina's prioriteit

Prioriteringsniveaus voor technische issues:

- Kritieke issues (directe aanpak): server downtime, indexeringsblokkades, beveiligingsproblemen

- Hoge prioriteit (binnen 30 dagen): broken links op belangrijke pagina's, duplicate content, mobiele problemen

- Medium prioriteit (binnen 90 dagen): interne linkstructuur, URL-optimalisatie, gestructureerde data

Data-gestuurde besluitvorming: Combineer je crawl data met analytics om een op impact gebaseerde prioriteringsmatrix te maken. Identificeer pagina's met hoge verkeerswaarde maar technische problemen, en behandel deze als hoogste prioriteit.

2. Implementatie tracking en validatie

Het oplossen van technische SEO-problemen is een iteratief proces. Te vaak zie ik dat bedrijven fixes implementeren zonder de impact te meten, waardoor ze kansen missen om te leren wat echt werkt.

Documentatie is hierbij essentieel. Door gedetailleerde fix-specificaties te maken voor ontwikkelaars, minimaliseer je miscommunicatie en zorg je dat wijzigingen correct worden uitgevoerd. Een systematisch QA-proces voorkomt dat nieuwe problemen ontstaan tijdens het oplossen van bestaande issues.

Praktische validatietips met Google Search Console:

- Gebruik de URL Inspection tool om te verifiëren dat fixes correct zijn geïmplementeerd en om herindexering aan te vragen

- Monitor de "Indexering" > "Pagina's" rapporten om te zien of het aantal geïndexeerde pagina's stijgt na implementatie

- Controleer de "Verbetering" rapporten voor Schema en andere structured data validatie na implementatie

- Bekijk crawlstatistieken in het "Crawlstatistieken" rapport om te zien of Googlebot efficiënter werkt na je optimalisaties

Kernelemenenten van effectieve implementatie:

- Gedetailleerde fix-specificaties documenteren voor ontwikkelaars

- QA-proces implementeren voor elke technische wijziging

- Impact meten via indexeringsratio's, crawl stats en rankings

Google Search Console Crawlstatistieken tip: Controleer het patroon van "Bytes gedownload per dag" tegenover "Pagina's gecrawld per dag". Een efficiënte site laat een hoog aantal pagina's zien met relatief weinig bytes, wat aangeeft dat Google efficiënt kan crawlen zonder onnodige resources te verspillen.

Een financiële dienstverlener implementeerde systematisch verbeteringen aan hun mobiele site-architectuur. Door elke verandering zorgvuldig te documenteren en de impact te meten, konden ze precies zien welke technische verbeteringen de grootste ROI opleverden, wat leidde tot een verbetering in mobiele conversies.

Geautomatiseerde monitoring voor continue optimalisatie

Een éénmalige technische audit is niet voldoende. Websites zijn dynamische entiteiten die voortdurende monitoring vereisen.

1. Continue monitoring-infrastructuur opzetten

In mijn praktijk heb ik gezien dat de meest succesvolle websites een robuuste monitoring-infrastructuur hebben die technische problemen detecteert voordat ze impact hebben op rankings of gebruikerservaring.

Regelmatige geautomatiseerde crawls vormen de basis van continue monitoring. Hiermee kun je nieuwe problemen vroeg identificeren, vooral na website-updates of content-toevoegingen.

Google Search Console monitoring strategie:

- Stel e-mailwaarschuwingen in voor kritieke problemen zoals indexeringsafnames of beveiligingsproblemen

- Plan wekelijkse inspectie van het "Coverage" rapport om nieuwe indexeringsproblemen te identificeren

- Controleer maandelijks de "Performance" rapporten met de filters ingesteld op "Pages" om onverwachte prestatiedalingen van specifieke pagina's te identificeren

- Monitor het "Mobile Usability" rapport na elke site-update om te zorgen dat mobiele optimalisatie gehandhaafd blijft

Essentiële monitoring-componenten:

- Wekelijkse of maandelijkse site-crawls inplannen

- Automatische alerts instellen voor kritieke problemen

- Crawl-vergelijkingen implementeren om trends te identificeren

Geautomatiseerde GSC rapportage: Gebruik Google Data Studio (nu Looker Studio) om een dashboard te maken dat GSC-data automatisch bijwerkt en belangrijke KPI's zoals indexeringsratio, gemiddelde positie en total impressions toont. Dit maakt problemen direct zichtbaar zonder handmatige controle.

Naast crawls is logfile-analyse een krachtige maar onderbenutte techniek. Door serverlogboeken te analyseren, krijg je direct inzicht in hoe zoekmachinebots met je site interacteren, en waar ze mogelijk problemen ondervinden.

2. Proactieve optimalisatie op basis van data

De meest geavanceerde aanpak is proactieve optimalisatie, waarbij je monitoring-data gebruikt om problemen te voorspellen en op te lossen voordat ze optreden.

Crawl budget optimalisatie is een perfect voorbeeld hiervan. Door te analyseren hoe Googlebot je site crawlt, kun je aanpassingen maken die ervoor zorgen dat je meest waardevolle content prioriteit krijgt in het indexeringsproces.

Praktische tips voor crawl budget optimalisatie via GSC:

- Gebruik het rapport "Crawlen" > "Crawlstatistieken" om te zien hoeveel pagina's Googlebot dagelijks crawlt

- Analyseer pieken en dalen in crawlactiviteit en correleer deze met site-updates of server issues

- Controleer welke pagina's Googlebot het vaakst bezoekt door het crawl-rapport te vergelijken met server logs

- Gebruik de robots.txt om crawling van lage-waarde pagina's te beperken zodat crawl budget naar belangrijkere pagina's gaat

Proactieve optimalisatiestrategieën:

- Crawl budget verdelen naar hoogwaardige content-secties

- Predictieve analyses gebruiken om problemen te voorspellen

- Concurrentie-benchmarking voor technische innovatie

Search Console Inspecties tip: Als je merkt dat bepaalde pagina-types niet goed worden geïndexeerd, gebruik dan de URL Inspection tool op meerdere voorbeelden om specifieke renderingsproblemen te identificeren. Je kunt het gerenderde HTML bekijken om te zien of kritieke content voor Google zichtbaar is.

FAQ's

Hier vind je antwoorden op de meest gestelde vragen. Heb je een specifieke vraag die hier niet beantwoord wordt? Neem gerust contact op.

Voor de meeste websites is een kwartaalaudit optimaal, aangevuld met continue monitoring. Bij grote sites of bij regelmatige ontwikkelingsveranderingen zijn maandelijkse mini-audits van kritieke secties noodzakelijk. Na significante site-updates, migraties of redesigns is een directe audit vereist.

Core Web Vitals, mobile-friendliness, HTTPS-implementatie en correcte indexeerbaarheid hebben de meest directe ranking-impact. De prioriteit verschilt per niche – e-commerce sites hebben meer baat bij snelheidsoptimalisatie, terwijl B2B-sites vaak meer winnen bij betere indexatie van complexe content.

Combineer drie factoren: organische verkeerimpact, conversiewaarde van betrokken pagina's, en implementatiecomplexiteit. Gebruik deze formule: Prioriteit = (Verkeerimpact × Conversiewaarde) ÷ Implementatiecomplexiteit. Zo focus je altijd op fixes met de hoogste ROI.

Voor kleinere sites werkt Screaming Frog uitstekend, grotere websites hebben baat bij Botify of DeepCrawl. Voor prestatiemonitoring is een combinatie van Lighthouse, WebPageTest en CrUX-data essentieel. Google Search Console blijft onmisbaar voor indexeringsanalyse. Serverloganalyse via tools als Splunk biedt unieke crawling-inzichten die andere tools missen.

Bright Secrets

Deze 'Bright Secrets' kunnen je helpen bij het ontwikkelen van je eigen aanpak.

1. Focus op crawl prioritization, niet alleen crawlability

Zorg dat search engines niet alleen je content kunnen crawlen, maar dat ze de juiste content met de juiste frequentie crawlen. Een goed geconfigureerd robots.txt, strategische interne linking en slimme XML sitemaps zorgen dat zoekmachines je meest waardevolle pagina's prioriteren.

2. Gebruik business metrics als prioriteringshulp

Prioriteer technische problemen door ze te koppelen aan business impact, niet alleen aan SEO-metrics. Los eerst problemen op die pagina's met hoge conversiewaarde, hoge omzet of strategische belangrijkheid beïnvloeden. Een redirect op een landingspagina met 10.000 maandelijkse bezoekers heeft meer prioriteit dan tientallen 404's op verlopen productpagina's.

3. Denk serverside, niet alleen clientside

De meeste SEO's focussen te veel op wat gebruikers zien en te weinig op wat zoekmachines ervaren. Server logs, crawl statistieken en indexeringsdata bieden diepere inzichten dan on-page elementen. De grootste technische verbeteringen komen vaak voort uit serveroptimalisaties, niet uit meta tag-correcties.

4. Maak van monitoring een cyclisch proces

Technische SEO is nooit "klaar". Implementeer continue monitoringsprocessen en behandel technische optimalisatie als een cyclisch proces. De meest succesvolle websites hebben cross-functionele teams die technische SEO-gezondheid integreren in hun reguliere ontwikkelingsprocessen, niet als eenmalig project.

Andere interessante artikels

ChatGPT Ads in 2026: Zo bereid je je advertentiestrategie nu al voor

OpenAI test sinds januari 2026 advertenties in ChatGPT. Dat verandert het speelveld voor digitale marketing fundamenteel. In dit artikel leg ik uit wat deze ontwikkeling betekent voor jouw advertentiestrategie en hoe je je nu al kunt voorbereiden.

De 4 beste AI app builders van 2026: Bouw apps zonder code

Stel je voor: een volledige applicatie bouwen zonder code te schrijven, binnen enkele uren in plaats van maanden. AI app builders maken dit mogelijk in 2026. Deze nieuwe generatie tools transformeert softwareontwikkeling door het toegankelijk te maken voor iedereen. Ontdek hoe de vier beste platforms - Lovable.dev, Bolt.new, Glide en Replit - de bouw van complexe apps vereenvoudigen, van interactieve wereldkaarten tot geavanceerde authenticatiesystemen. Plus: een overzicht van opkomende alternatieven die je moet kennen.

Base44 vs Lovable: Welke AI app builder levert écht resultaat in 2026?

De markt overspoelt je met AI app builders. Na uitgebreid testen van Base44 en Lovable voor klantprojecten, deel ik mijn ongezouten waarheid. Deze vergelijking helpt je kiezen tussen snelle prototypes (Lovable) of schaalbare production apps (Base44).

ChatGPT Atlas VS Claude Browser Agent: Welke AI-assistent transformeert jouw browser het best?

OpenAI's Atlas browser vs Anthropic's Claude Chrome extensie - praktische vergelijking na 3 weken testen. Ontdek welke AI-assistent het beste past bij jouw workflow.

4 big wins om zichtbaar te blijven in Google AI Overviews

Ontdek 4 bewezen strategieën om zichtbaar te blijven in Google AI Overviews. Van 40-woorden regel tot E-E-A-T signalen - praktische wins die direct werken.

.webp)